オープンソースLLM Top 5 (2024)

2023/01/12 | 3分LLM 2023年の月別ホットニュース総まとめレポートを 受け取りましょう

これだけは知っておきたいLLMのニュースと2024年の将来動向を一挙にまとめました。

オープンソースLLMのメリット

生成AIへの関心が高まる中、人工知能市場の 판도는様々なオープンソースの登場とともに変化しています。今年発売が予定されているフロンティア大型言語モデル(LLM)だけでも10個を超えることが分かりました。 オープンソースLLMは、アクセス性、透明性、費用効率などのメリットで注目されています。これらの特性により、企業はニーズに応じてカスタマイズして使用することができ、ファインチューニングを通じて膨大な量のデータ学習や独自のシステム開発なしに新しいモデルを迅速に開発することができます。このような強みのおかげで、AI技術を発展させるためには健全なオープンソースの生態系を育てていかなければならないという業界の声も高まっています。 以下では、オープンソースLLMのメリットをもう少し詳しく見ていきましょう。

- 高速かつ柔軟な開発環境

: コミュニティを通じて、複数の人が同じプロジェクトに貢献しながらアイデアを交換し、問題を解決できる環境が構築され、バグ修正や技術的な問題を改善する作業が迅速に行うことができます。これはメンテナンスの面でも効果的です。

- 高いアクセシビリティと拡張性

: ユーザーのニーズに応じてコードを修正したり、拡張してプロジェクトの目的に合わせてカスタマイズすることができます。

- 透明性を基に教育と研究の機会を提供

: オープンソースLLMの透明性は関連研究を促進し、学生や研究者に教育的なリソースとして活用されます。

- コスト削減

: 独自のシステムを開発しなくても無料で使用できるオープンソースソフトウェアを活用すれば、コストと時間を削減することができ、スタートアップや企業が新しい製品やサービスを開発する際に資本の負担を軽減することができます。

LLMモデルの導入動向 (出典: A Comprehensive Overview of Large Language Models)

本格的なオープンソースLLMブームは、2023年2月にメタがLLaMaを学界に公開したことから始まりました。 これをきっかけにLLaMaをベースにした複数の「sLLM」(小さな大型言語モデル)が登場しましたが、sLLMは通常パラメータが60億(6B)~100億(10B)個と、従来のLLMに比べてはるかに小さいにもかかわらず、性能は劣らないため、低コスト・高効率の強みを持ちます。オープンAIの「GPT-3」はパラメータが1750億個、Googleの「LaMDA」(ラムダ)が1370億個、「PaLM」(パーム)が5400億個に達するのと比較すると、効率をより体感することができます。

では、2024年に注目すべき最高のオープンソースLLMの5つは何でしょうか?

2024年に注目すべきオープンソースのトップ5

1.ラマ2

出典: メタAI

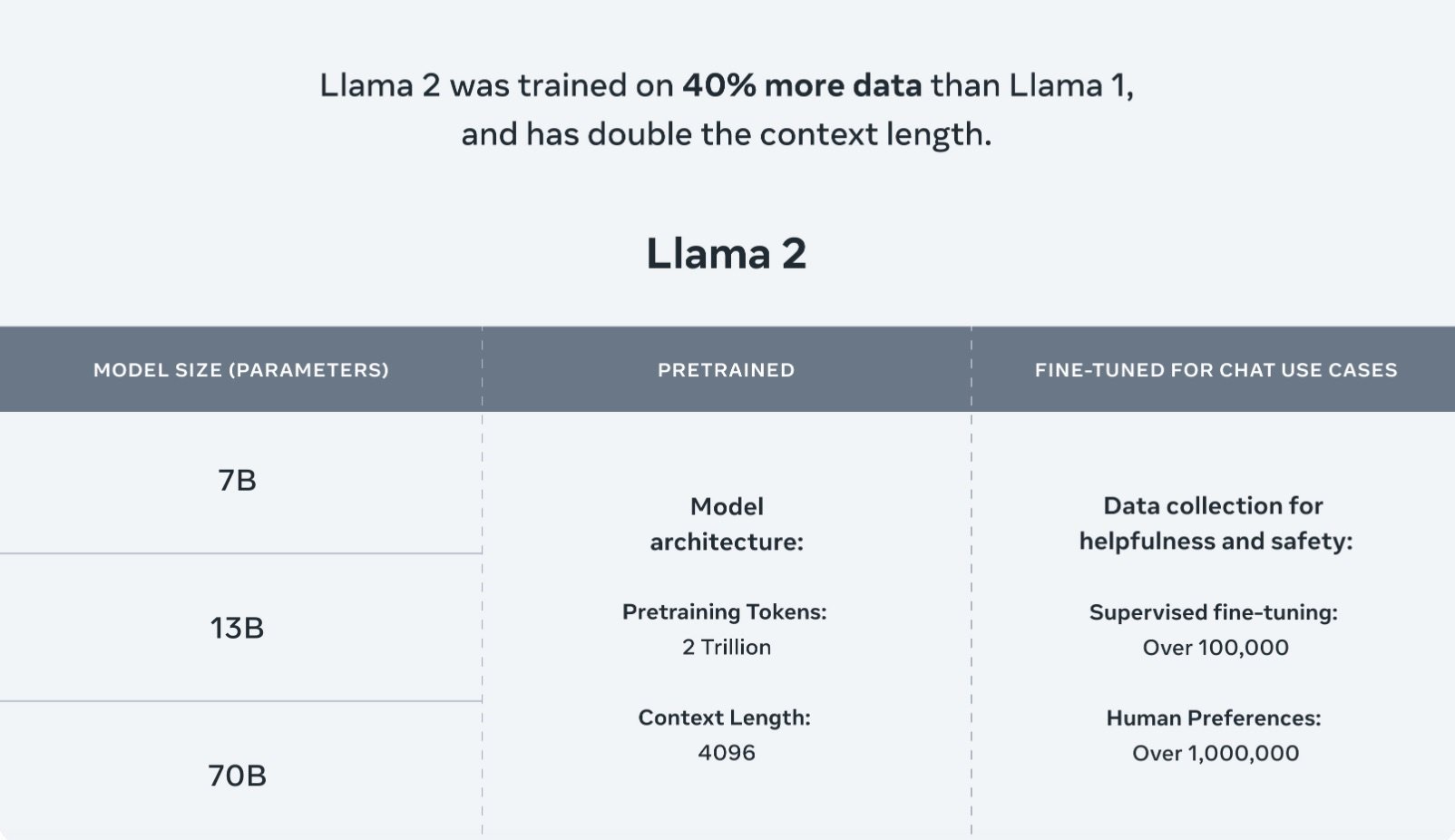

Llama 2はメタAIが開発したオープンソースLLMで、最も人気のあるオープンソースLLMの一つです。Llama 2はLlamaの最初の商用バージョンで、2023年7月18日にリリースされました。7Bから70Bまで4つのサイズを提供し、Llama 2の事前学習データはLlama 1よりも大きな2兆個のトークンで構成されています。

標準トランスフォーマーアーキテクチャを活用するLlama 2は、RMSNorm(Root mean square layer normalization)やRoPE(Rotary Positional Embedding)などの新機能を適用します。Llama 2のチャットは、supervised fine-tuning(微調整)から始まり、RLHF(Reinforcement learning from human feedback)によって改善されます。Llama 1と同じトークナイザーであるByte Pair Encoding(BPE)アルゴリズムとSentencePieceを使用しています。 また、LLMで重要な問題である真実性、有害性、バイアスに対する懸念を解消するために、安全性チェックに注意を払っています。AzureやWindowsをはじめとする様々なプラットフォームで微調整が可能なように拡張され、様々なプロジェクトに役立ちます。

人間のフィードバックによる強化学習(RLHF)と報酬モデリングで双方向会話に最適化したLLaMA 2-Chat (出典: Meta AI)

2.ミストラル

Mistral-7B は Mistral AI がリリースしたモデルで、カスタマイズされた学習とチューニングおよびデータ処理方法に基づいて作られました。 このモデルは Apache 2.0ライセンスで提供されるオープンソースモデルで、実際のアプリケーションに適用できるように設計され、効率的で高い性能を提供します。リリース時に評価されたすべてのベンチマークで、最高のオープンソース13Bモデルの一つであるLlama 2と比較して優れた性能を発揮しました。 このモデルは、数学、コード生成、推論を含む様々なベンチマークで優れた性能を発揮します。

様々なベンチマークでのMistral 7BとLlamaモデルの性能比較(Source: Mistral 7B)

Mistral-7BのようなMistral-Tinyモデルは、複雑な計算を必要としない大容量バッチ処理作業に適しています。このモデルは、アプリケーションにとって最も費用対効果の高いモデルです。Mistral-small (Mistral 8x7B Instruct v0.1)は、英語、フランス語、イタリア語、ドイツ語、スペイン語の5つの言語をサポートし、コード生成に優れた性能を発揮します。Mistral-mediumは、GPT-3.5を上回る高性能のプロトタイプモデルを使用することで知られています。これは、高品質のアプリケーションに適しています。

3.ソーラー

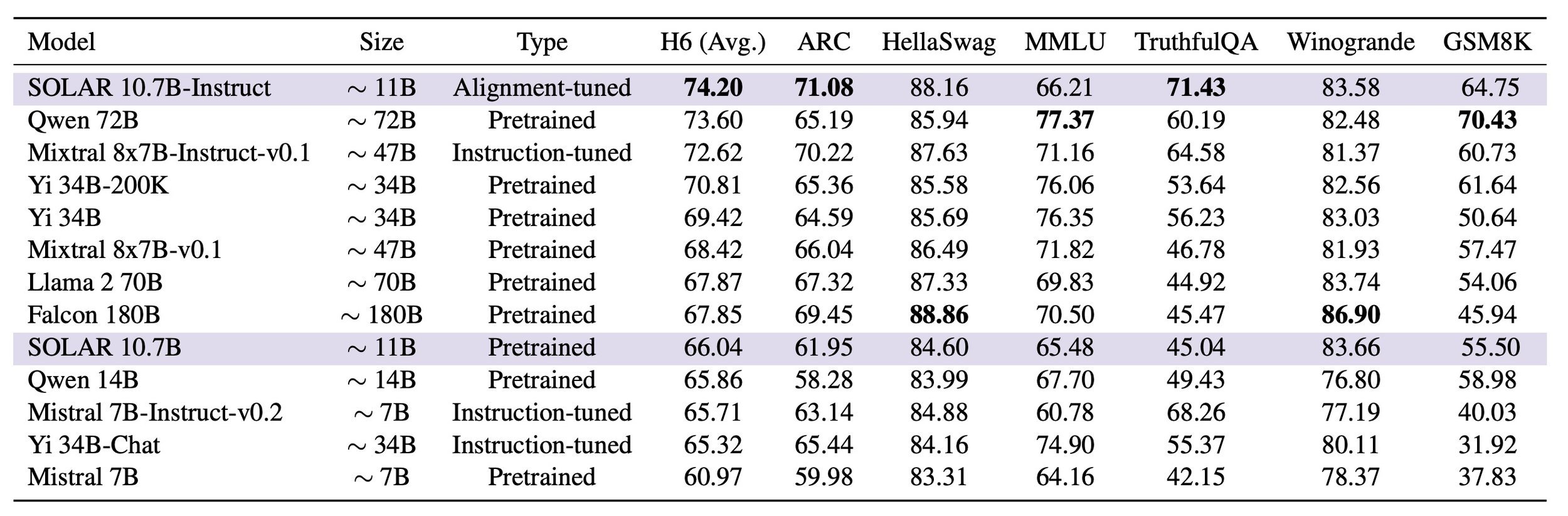

Solar(ソーラー)はアップステージがリリースした小型言語モデルです。107億個のパラメータを持つSolar 10.7Bは、既存のLlama 2やMistral-7Bなどのモデルよりも、本質的なNLP(自然言語処理)タスクでより優れたパフォーマンスを発揮しながら、効率を維持する最新かつ最高のオープンソースLLMです。2023年12月には、世界最大の機械学習プラットフォームであるHuggingfaceが運営する「オープンLLMリーダーボード」で1位を達成しました。 この結果は、小型LLM(sLM)の基準と言える300億パラメータ(30B)以下のサイズで、グローバル最高性能モデルにランクインしたため、より意味があります。

小さなサイズで構成されたSolarモデルの性能を最適化するために、Upstageは「Depth Up-Scaling」手法を使用しました。 これは、性能が良いが大きい13Bモデルと十分に小さいが知的制約がある7Bモデルの間の利点を組み合わせるために、最適なモデルサイズを見つけるための方法で、Upstageはオープンソースの7Bモデルをベースに独自のDepth Up-Scaling方式を適用し、レイヤーを追加し、深さを加えて小型モデルの性能を最大化しました。MoE(mixture-of-experts) とは異なり、Depth Up-Scalingはトレーニングや推論に複雑な変更を必要としません。 このようなアプローチのおかげで、Solarは3兆個以上のトークンの優れたデータを通じて拡張された10.7Bで発売され、最適なサイズと性能を組み合わせることができました。

特に、Solarは事前学習とファインチューニングの段階でリーダーボードベンチマークデータセットを使用せず、独自に構築したデータを適用しました。 これは、リーダーボードのスコアを上げるためにベンチマークセットを直接適用する他のモデルの事例とは異なり、Solarが実際の業務で様々なタスクに活用するなど、高いユーザビリティを発揮できることを示しています。

SOLAR 10.7BおよびSOLAR 10.7B-Instructと他の言語モデルに対する評価結果 (出典: SOLAR 10.7B: Scaling Large Language Models with Simple yet Effective Depth Up-Scaling)

4.李

Yi-34Bは、8ヶ月で10億ドル以上の価値を認められ、ユニコーン企業に成長した中国のスタートアップ01.AIが開発しました。 Yiシリーズは、多言語モデルを目指し、モデル学習に高品質の3T多言語コーパスを活用しました。 これは、言語理解力、常識推論、読解力などで注目すべき性能を示しました。Yi は6Bおよび34Bサイズのモデルを提供し、推論時間中に32Kまで拡張することができます。

YiのGitHubによると、6Bシリーズモデルは個人用と学術用に適しており、34Bシリーズモデルは商業用と個人用、学術用に適しているとのことです。YiシリーズモデルはLLaMAと同じモデルアーキテクチャを使用しているため、ユーザーはLLaMAのエコシステムを活用することができます。01.AIは生成型AI市場のリーダーを目指し、今年、改善されたモデルを発売し、商用製品を拡大する計画です。

6.ファルコン

出典: 技術革新研究所

Falconはアラブ首長国連邦(UAE)の技術革新研究所が発売した生成型大規模言語モデルです。 このモデルは180B、40B、7.5B、1.3BパラメータのAIモデルを提供します。Falcon 40Bは、研究者と商業ユーザーの両方にロイヤリティフリーで提供されています。11言語で動作可能で、特定の要件に合わせてファインチューニング(微調整)することができます。Falcon 40Bは、GPT-3やChinchilla AIよりも少ないトレーニングコンピューティングリソースを使用し、高品質のトレーニングデータに焦点を当てています。180Bモデルは1800億個のパラメータを持ち、3.5兆個のトークンを学習し、優れた性能を発揮します。

オープンソースLLMで開くAIの未来

今やAI市場でLLMを抜きにして変化と革新を論じることは難しいほど、LLMは様々な産業群に適用され、新しいアイデアと技術を誕生させています。 そのため、誰でも参加し、改善し、学習できる生態系を提供するオープンソースLLMは、AIの未来を変える革新的な役割を果たすことになるでしょう。 オープンソースLLMで発展するAI技術は、今年、私たちにどんな驚きをもたらすのか注目されます。

☀️ ソーラーLLM

[NEW】アップステージのソーラー10.7Bについて

Open LLMリーダーボードで競合モデルを上回るパフォーマンスを発揮した10.7Bモデルをご紹介します。

![[報道写真]アップステージ、事前学習LLMソーラーを公開...グローバルLLM大戦本格参戦.jpeg](https://images.squarespace-cdn.com/content/v1/618b246f4dfdef45045a78dd/1702508852298-V88O6QBP5TCJVZP9KMI8/%5B%EB%B3%B4%EB%8F%84%EC%82%AC%EC%A7%84%5D%EC%97%85%EC%8A%A4%ED%85%8C%EC%9D%B4%EC%A7%80%2C+%EC%82%AC%EC%A0%84%ED%95%99%EC%8A%B5+LLM+Solar+%EA%B3%B5%EA%B0%9C%E2%80%A6+%EA%B8%80%EB%A1%9C%EB%B2%8CLLM+%EB%8C%80%EC%A0%84+%EB%B3%B8%EA%B2%A9+%EC%B0%B8%EC%A0%84.jpeg)